[ACL 2024] 효율적인 언어모델을 향하여

초거대 언어모델(Large Language Model, LLM)의 발전으로 다양한 영역에서 괄목할 만한 성과가 나타나고 있습니다[3,4,5]. 특히 자연어 이해, 생성, 다양한 언어 간 번역, 요약, 질문 답변 등의 전문 응용 분야, 코드 생성과 같은 영역에서의 발전은 주목할 만합니다. LG AI연구원의 EXAONE[3] 과 OpenAI의 GPT-4, Google의 PaLM 2, Meta의 LlaMA[4] 등 모델들은 복잡한 추론 작업에서 뛰어난 발전을 이루었습니다. 긴 대화에서 문맥을 해치지 않는 일관성을 보였으며, 맥락에 맞는 결과를 출력했습니다.

그러나 이들 모델이 점점 더 거대하고 복잡해지고 때로는 수천만 개의 파라미터를 다루는 상황에도 놓이게 되면서, AI 모델은 학습 및 추론과 관련한 중대한 도전에 마주하게 되었습니다[1 ,2, 6]. AI 모델을 학습시키는 데에는 방대한 연산 능력이 요구되기 때문에 시간이 오래 걸리고 큰 비용이 발생합니다. 몇 주, 몇 달간 작동시키기 위해 GPU, TPU와 같은 전문적인 하드웨어가 필요하기도 합니다. 더군다나 이러한 거대 모델을 애플리케이션 형태로 현실 세계에 배포하면, 추론 속도가 떨어지고 리소스 소모가 커지면서 기기에 따라 제 성능을 내지 못하는 문제가 발생하기도 합니다. 예를 들어, 멀티 노드 추론이 필요한 LlaMA 405B 모델은 모델의 크기와 복잡성을 다루기 위해 여러 대의 기기를 조직적으로 구성해야 합니다. 이렇게 구성하면 추론 자체에 큰 비용이 발생할 뿐만 아니라 기술적인 난이도도 높아져 모델들의 확장성과 접근성에 제한이 생기게 됩니다.

따라서 최근에는 더 효율적인 알고리즘과 아키텍처를 개발하는 데 중점을 두고 범용적 사용이 가능한 실용성을 갖춘 LLM, 지속 가능하게 사용할 수 있는 LLM을 만드는 것을 목표로 연구가 진행되고 있습니다.

이번 글에서는 ACL 2024에서 발표된 관련 연구를 분석하고, 특히 LLM의 효율성을 개선하는 데 집중한 다양한 접근 방법을 깊이 있게 살펴보고자 합니다. 또한 이들 모델의 성능과 자원 사용을 최적화하기 위한 방법을 다룬 주요 논문과 혁신을 조명해보고 인사이트를 정리해보겠습니다.

1. LayerSkip: Enabling Early Exit Inference & Self-Speculative Decoding (Meta)[1] 요약

LayerSkip은 LLM의 추론을 빠르게 하기 위해 고안된 방법입니다. 여기에는 Early Exit을 개선하기 위해 Layer Dropout과 Early Exit Loss Function을 사용하여 모델을 학습시키는 것이 포함됩니다. 이 방법은 추론 과정 동안 Early Exit 하는 Self-speculative Decoding 기법을 활용하고 나머지 레이어를 통해 결과를 검증하여 메모리 사용량을 줄이고 효율성을 개선합니다.

동기

이 연구는 LLM의 Early Layers가 정확한 예측을 생성하기도 한다는 관찰에 기반합니다. 예를 들어 이미지 1을 보면 Llama1 7B의 Lower Layers에 의해 예측된 토큰들이 올바른 경우가 몇몇뿐이라는 것을 볼 수 있습니다. 이는 전체 모델보다 더 적은 수의 레이어로 정확한 예측이 만들어질 수 있으며, 즉 모델의 연산 리소스가 비효율적으로 사용될 수 있다는 것을 시사합니다. GPT-2 모델에서도 유사한 결과가 관찰되었습니다.

이미지 1. Llama1 7B 모델의 각 레이어에서 예측된 토큰.

이는 여전히 Early Layers가 상대적으로 높은 정확도로 올바른 예측을 생성한다는 것을 보여줍니다[1].

접근 방법

접근 방법은 LLM의 추론 효율성을 개선하기 위해 고안된 3개의 주요 단계로 구성됩니다.

-

Layer Dropout 및 Early Exit Loss를 통한 학습: Layer Dropout 및 Early Exit Loss를 통한 학습에는 전통적인 Dropout 방법을 적용하여 Transformer 모델의 학습 효율성을 개선하는 것이 포함됩니다. 이 접근 방법은 Dropout을 균일하게 적용하기보다는 샘플과 Timestep에 따라 달라지는 Per-layer 기반의 Dropout Probabilities에 맞춰져 있습니다.

Layer Dropout 이외에도 Early Exit Loss는 Lower Layers의 예측 정확도를 개선하기 위해 도입되었습니다. 학습하는 동안 모델의 언어 모델링 헤드(LM 헤드)는 다양한 레이어의 출력을 처리하도록 설계되었습니다. Early Exit Loss는 각 레이어에 적용되어 언어 모델링 작업에 대한 Lower Layers의 기여분을 직접적으로 감독합니다. Total Loss Function은 Early Exit이 각 레이어에 대해 활성화되었는지 여부를 결정하는 Binary Curriculum Function에 의해 조정된 Normalized Per-layer Loss Scale을 사용합니다. 이 Scaling은 레이어 전반에 걸쳐 증가하며 예측이 일반적으로 더 쉬운 후기 레이어에 더 높은 페널티를 부여합니다. 이 접근 방법은 추가 LM 헤드를 추가하지 않지만 모든 레이어에 걸쳐 하나의 LM 헤드만 활용한다는 점이 주목할 만합니다.

-

Early Exit을 통한 추론: 추론 시간에 모델은 사전 정의된 수의 레이어(E) 이후에 Early Exit 하며 나머지 레이어를 건너뛰고 직접적으로 최종 출력에 Mapping됩니다. 이는 전체 모델을 사용했을 때보다 계산 비용을 감소시킵니다.

-

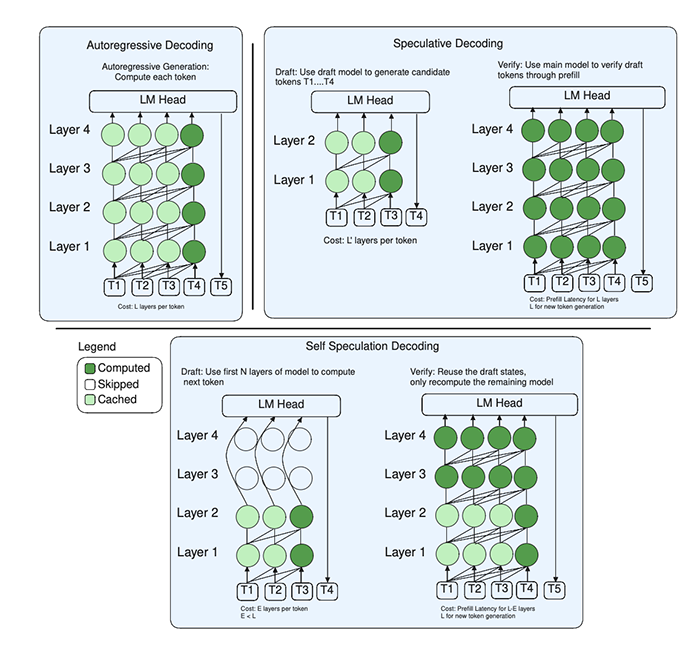

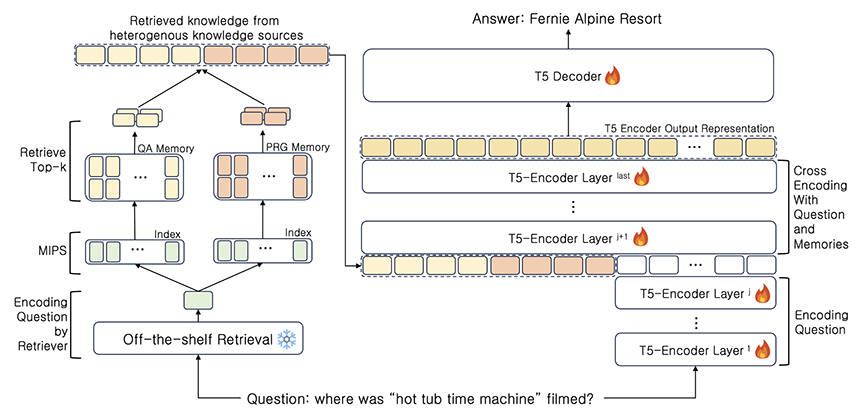

Self-speculative Decoding: Early Exit의 정확도 손실을 해결하기 위해 새로운 Self-speculative Decoding 방법이 사용됩니다. 여기에는 Early Exit을 통해 초기 예측 생성(Drafting) 후 나머지 레이어를 사용하여 이들 예측을 검증하고 교정하는 것이 포함됩니다. 이 기법은 Drafting 단계의 연산을 재사용하여 효율성을 개선하고 메모리 사용량을 감소시킵니다.

다시 설명하자면, Draft 모델은 자체적인 Early Layers이며, 따라서 거대 모델(모델 자신)을 통해 추론 실행 시 Draft 모델에 의해 매핑된 숨겨진 상태가 재사용될 수 있습니다. 그 과정은 이미지 2에서 확인할 수 있습니다.

이미지 2. 접근 방법에서 Self-speculation Decoding이 어떻게 빠르고 효율적인 추론을 가능하게 하는지에 대한 설명[1]

전반적으로 이 접근 방법은 혁신적인 학습 기법을 효율적인 추론 전략과 결합하여 정확성을 유지하면서도 LLM의 속도를 향상시킵니다.

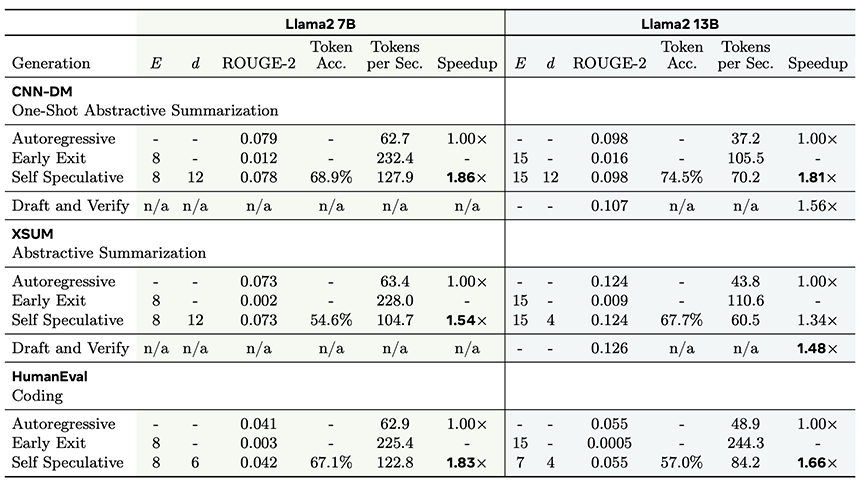

결과

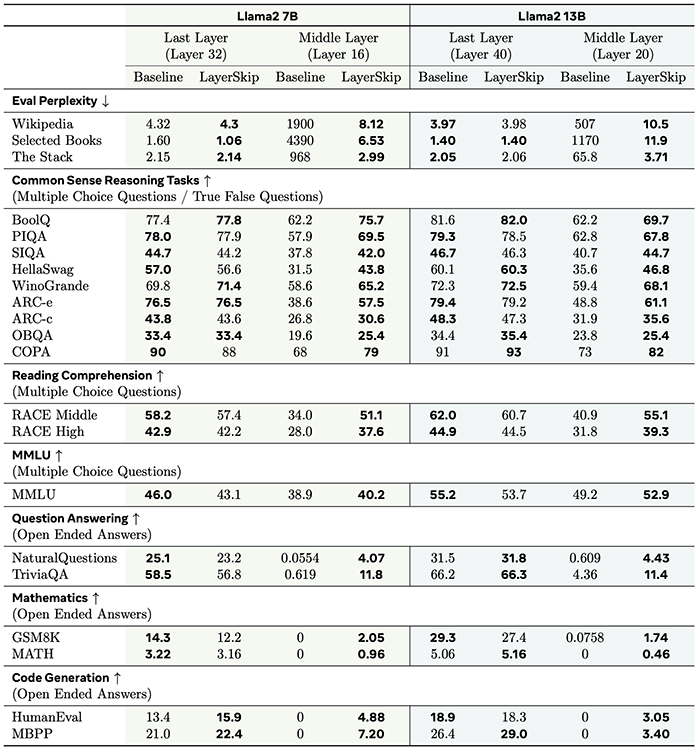

이미지 3. 해당 접근 방법을 통해 학습된 Llama2 7B 및 Llama2 13B 평가[1]

이 결과는 해당 접근 방법이 기준 모델(기존의 Llama 모델)의 성능과 비교했을 때 경쟁력 있으며, 몇몇 경우에는 이를 능가하기도 한다는 것을 나타냅니다. 예를 들어, 코드 생성 작업에 있어 해당 방법은 Llama2 7B 기준 모델을 월등하게 압도합니다.

이미지 4. 속도 분석[1]

이와 더불어, 이미지 4는 해당 접근 방법을 통해 달성된 속도 개선을 보여줍니다. 해당 방법은 Self-speculative Decoding을 활성화함으로써 CNN-DM 작업 및 코드 생성 작업 모두에서 기준에 비해 1.83배 증가한 속도를 달성했습니다.

2. MATTER: Memory-Augmented Transformer Using Heterogeneous Knowledge Sources (Amazon)[2] 요약

이 연구는 질문 답변과 같이 지식이 크게 요구되는 작업에서 전통적인 검색-리드(Retrieve-and-read) 접근 방법의 한계를 극복하기 위해 고안된 효율적인 메모리 증강 트랜스포머(Memory-augmented Transformer)인 MATTER를 제시합니다. MATTER는 고정 길이 뉴럴 메모리(Fixed-length Neural Memory)로 대표되는 비정형(예: 단락) 소스 및 반정형(예: QA 쌍) 소스 모두를 포함한 여러 다른 종류의 소스에서 관련 지식을 검색함으로써 성능을 개선합니다. 이 모델은 다양한 지식 소스를 보다 효율적으로 다룸으로써 전통적인 방법과 비교했을 때 연산 비용과 속도 지연을 뚜렷하게 개선합니다.

동기

이 연구는 자연어 처리 작업, 특히 오픈 도메인 질문 답변(Question Answering, QA)에서 현행 검색 증강(Retrieval-augmented) 모델의 치명적인 한계 극복에 중점을 두고 있습니다. 일반적으로 이들 모델은 2단계로 된 절차를 따릅니다. 먼저, 모델은 지식 소스에서 관련 정보를 가져옵니다. 이후 정보를 읽고 이해하여 응답을 생성합니다. 하지만 이러한 효율성에도 불구하고 이들 모델은 다음과 같은 2가지 중대한 문제를 가지고 있습니다.

-

추론 지연 심화: 추론 지연 현상은 검색 증강 QA 모델 성능을 저하시키기도 합니다. 검색 단계가 읽기 단계에 컨텍스트 길이(Context length) 증대를 초래함으로써 이 문제가 발생합니다. 예를 들어, Fusion-in-Decoder와 같은 모델은 상당한 토큰 수를 가진 수많은 문서를 검색합니다. 그리고 응답을 생성하는 동안 리더 모델(Reader Model)이 수천 개의 토큰을 처리도록 합니다. 이처럼 컨텍스트 길이 증대는 병목을 초래하여 처리 속도를 저하시킵니다. 심지어 T5-base와 같은 더 작은 모델조차 초당 10개 이상의 질문을 처리하는 데 어려움을 겪습니다. 이러한 지연 문제는 리더 모델이 처리해야 하는 컨텍스트 길이가 증가하기 때문에 발생하며, 모델의 효율성에 영향을 미칩니다.

-

지식 소스에 대한 제한된 초점: 현존하는 검색 증강 모델은 일반적으로 비정형 데이터(예: Wikipedia 단락) 또는 반정형 데이터(에: QA 쌍)와 같은 단일 유형의 지식 소스에 의존합니다. 각 지식 소스 유형에는 각각 장단점이 있는데, 비정형 데이터는 방대하고 쉽게 접근할 수 있지만 노이즈가 들어 있고 정확도가 부족할 수 있습니다. 반면 반정형 데이터는 간결하고 명확하지만 수집하기 어렵습니다. 이러한 제한된 초점은 다양한 지식을 효율적으로 다루고자 하는 모델의 성능을 제한합니다. 지식 소스들을 결합하려는 최근 접근 방법들은 종종 비정형 텍스트를 QA 쌍으로 바꾸는 것과 같은 고비용 변환 작업이 포함되어 있으며, 이는 정보 변형이나 오류로 이어질 수 있습니다.

접근 방법

MATTER 접근 방법은 오픈 도메인 QA를 다루며, 추론 지연 시간은 감소시키고 이에 사용되는 지식 소스 유형을 넓히는 데에 중점을 둡니다. 기존 검색 증강 QA 시스템에서는 먼저 모델이 관련 정보를 지식 소스에서 가져온 후, 그 정보에 기반하여 답변을 생성합니다. 반면에 MATTER는 검색한 지식 표현을 위해 원시 텍스트를 처리하는 대신 뉴럴 메모리를 사용함으로써 추론 속도를 증대시켰습니다. 또한 MATTER는 QA 쌍, 단락과 같은 다양한 유형의 지식 소스를 지원하여 모델이 활용 가능한 정보 범위를 확장했습니다.

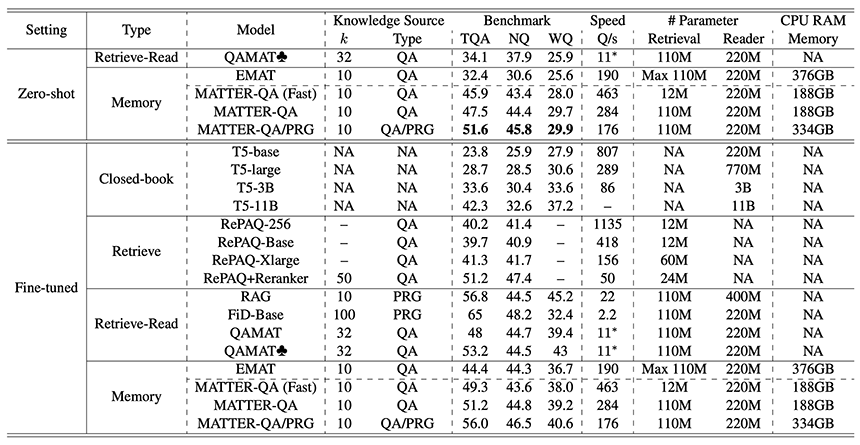

MATTER 모델은 T5-base 인코더와 디코더를 핵심 리더로 사용합니다. 이 모델은 최종 인코딩 단계(인코더의 마지막 n개의 레이어에서 크로스 인코딩)에서 질문과 메모리를 결합하기 전에 별도로 인코딩합니다. 뉴럴 메모리 표현은 고정 길이이며 지식 구조에 구애받지 않고 다양한 지식 유형에 적용할 수 있습니다. 이미지 5에서 전반적인 프레임워크를 볼 수 있습니다.

이미지 5. MATTER의 전반적인 프레임워크 질문은 인코더와 검색기(Retriever)에 모두 입력됩니다.

메모리가 검색되고 질문이 매핑되면, 이들은 나머지 인코더 레이어에서 크로스 인코딩됩니다.

이 그림에서 메모리 크기는 2이고 검색기는 4개입니다[2].

MATTER 학습에는 다음과 같은 두 가지 요소가 관여합니다. 먼저, 뉴럴 메모리가 원시 지식을 정확히 반영하도록 하는 Auto-encoding Loss가 있으며, 가져온 메모리에 기반하여 모델이 올바른 답변을 생성하도록 하는 Memory-augmented Generation Loss가 있습니다. QA 쌍만 사용하는 모델(MATTER-QA)의 경우, Loss Function은 이들 요소를 결합합니다. QA 쌍과 단락을 모두 포함하는 모델(MATTER-QA/PRG)의 경우, 단락에 대해 추가적인 Loss Term이 포함됩니다. 이 접근 방법은 모델의 속도를 높일 뿐만 아니라 다양한 유형의 지식을 다루는 능력을 개선함으로써 성능을 높이고 보다 다양한 상황에 사용될 수 있도록 만듭니다.

결과

이미지 6. 자주 사용되는 오픈도메인 QA 작업에 대한 실험 결과[2]

MATTER 접근 방법에 대한 평가는 기존 모델에 비해 주목할 만한 성능 향상과 속도 우위를 보여줍니다. Zero-shot 설정에서 MATTER-QA 및 MATTER-QA/PRG 모두 다양한 데이터세트에 걸쳐 메모리 기반 효율성 기준 모델인 QAMAT[7] 및 EMAT[8]의 성능을 크게 뛰어넘었습니다. MATTER-QA는 TQA 데이터세트에 대해 EM 점수 47.5점을 획득한 반면 EMAT은 32.4점, QAMAT는 34.1점을 획득했습니다. 이러한 성능 차이는 MATTER-QA/PRG가 QA 쌍 및 Wikipedia 단락을 모두 사용했을 때 더욱 벌어져 EM 점수 51.6점을 달성했습니다. 파인 튜닝된 설정에서도 MATTER 모델은 경쟁력이 있었으며 FiD 및 RAG와 같은 모델과 비교했을 때 더 빠른 추론 속도와 높은 QA 성능의 균형을 달성했습니다. MATTER-QA 및 MATTER-QA/PRG은 최소 10배 더 빠른 속도를 내면서도 각각 EM 점수 51.2점, 56.0점을 달성했습니다. 더 작은 Retriever를 사용하는 MATTER-QA(Fast) 변형 모델은 성능은 살짝 낮지만 초당 463개의 질문을 처리하여 모델의 유연성과 효율성을 입증했습니다. 전반적으로 MATTER 모델은 높은 정확성과 인상적인 속도를 보이며 두 지표에서 모두 기존 모델을 뛰어넘었습니다.

결론

ACL 2024에서는 LLM의 효율성을 개선하는 데 초점을 맞춘 영향력 있는 논문이 여러 편 발표되었고, 이번 글에서는 Layer-skip 및 MATTER라는 두 가지 주목할 만한 접근 방법을 살펴봤습니다. 두 접근 방법을 통해 LLM의 효율성을 높이기 위한 연구의 수준이 현저하게 높아졌고, 연구가 크게 발전했음을 확인할 수 있었습니다.

LG AI연구원 역시 LLM의 효율성 개선이 중요하다는 점을 인식하고 있습니다. 지난 8월에는 성능과 경제성이 강화된 EXAONE 3.0을 공개한 바 있고, 이를 포함해 LLM의 효율성을 개선하기 위한 노력도 끊임없이 이어가고 있습니다. LG AI연구원은 앞으로도 사용자의 니즈를 충족시킬 수 있고 전반적인 효율성을 개선해 성능도 최적화한 모델 개발에 매진하겠습니다.

ACL Trends Review Series

#1. [ACL 2024] LLM 연구의 최신 트렌드와 주요 인사이트

#2. [ACL 2024] 차트 이해 및 추론을 위한 새로운 접근 방법

#4. [ACL 2024] AI-generated Text Detection 최신 연구 동향

#5. [ACL 2024] LLM 신뢰성에 대한 평가 방법론과 효율성 연구의 트렌드

#6. [ACL 2024] 문화 간 차이를 고려한 LLM 연구 트렌드

- 참고

[1] LayerSkip: Enabling Early Exit Inference and Self-Speculative Decoding, ACL, 2024.

[2] MATTER: Memory-Augmented Transformer Using Heterogeneous Knowledge Sources, ACL-Findings, 2024.[3] EXAONE 3.0 7.8B Instruction Tuned Language Model, arxiv.

[4] LLaMA: Open and Efficient Foundation Language Models, arxiv.

[5] Language Models are Few-Shot Learners, NeurIPS, 2020.

[6] FiDO: Fusion-in-Decoder optimized for stronger performance and faster inference, ACL-Findings, 2023.

[7] An Efficient Memory-Augmented Transformer for Knowledge-Intensive NLP Tasks, EMNLP, 2022.

[8] Augmenting Pre-trained Language Models with QA-Memory for Open-Domain Question Answering, EACL, 2023.